Historia y evolución de los monitores

Que es?

El monitor es el principal periférico de salida de una

computadora. Estos se conectan a través de una tarjeta gráfica conocida con el

nombre de adaptador o tarjeta de vídeo.

Partes de un monitor

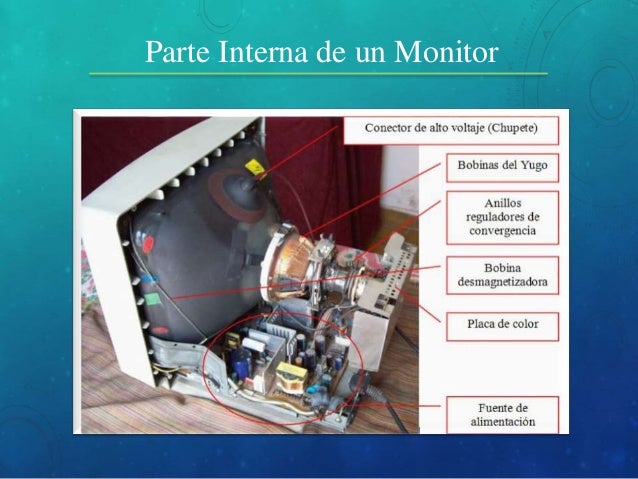

Internas

Historia

Las primeras

computadoras se comunicaban con el operador mediante unas pequeñas luces, que

se encendían o se apagaban al acceder a determinadas posiciones de memoria o

ejecutar ciertas instrucciones.

Años más tarde

aparecieron ordenadores que funcionaban con tarjeta perforada, que permitían

introducir programas en el computador. Durante los años 60, la forma más común

de interactuar con un computador era mediante un teletipo, que se conectaba

directamente a este e imprimía todos los datos de una sesión informática. Fue

la forma más barata de visualizar los resultados hasta la década de los 70,

cuando empezaron a aparecer los primeros monitores de CRT (tubo de rayos

catódicos). Seguían el estándar MDA (Monochrome Display Adapter), y eran monitores monocromáticos (de un solo color) de

IBM.

Estaban expresamente diseñados para modo texto y soportaban

subrayado, negrita, cursiva, normal e invisibilidad para textos. Poco después y

en el mismo año salieron los monitores CGA (Color Graphics Adapter –gráficos

adaptados a color–) fueron comercializados en 1981 al desarrollarse la primera

tarjeta gráfica a partir del estándar CGA de IBM. Al comercializarse a la vez

que los MDA los usuarios de PC optaban por comprar el monitor monocromático por

su costo.

Tres años más tarde surgió el monitor EGA (Enhanced Graphics Adapter - adaptador de

gráficos mejorados) estándar desarrollado por IBM para la visualización de

gráficos, este monitor aportaba más colores (16) y una mayor resolución. En

1987 surgió el estándar VGA (Video Graphics Array - Matriz gráfica de video) fue un estándar muy acogido y

dos años más tarde se mejoró y rediseñó para solucionar ciertos problemas que

surgieron, desarrollando así SVGA (Super VGA), que también aumentaba colores y resoluciones, para

este nuevo estándar se desarrollaron tarjetas gráficas de fabricantes hasta el

día de hoy conocidos como S3 Graphics, NVIDIA o ATI entre otros.

Evolución del monitor

Ordenador de tarjetas perforadas

LOS COMIENZOS

Las primeras computadoras se comunicaban con el operador mediante unas pequeñas luces, que se encendían o se apagaban al acceder a determinadas posiciones de memoria o ejecutar ciertas instrucciones.

Años más tarde aparecieron ordenadores que funcionaban con tarjeta perforada, que permitían introducir programas en el computador.

Teletipos en la 2ª guerra mundial

DÉCADA DE LOS 60

La forma más común de interactuar con un computador era mediante un teletipo, que se conectaba directamente a este e imprimía todos los datos de una sesión informática. Fue la forma más barata de visualizar los resultados hasta la década de los 70.

Monitor con tecnología CRT y estándar MDA

DÉCADA DE LOS 70

Empezaron a aparecer los primeros monitores de CRT(tubo de rayos catódicos). Seguían el estándar MDA (Monochrome Display Adapter), y eran monitores monocromáticos (de un solo color) de IBM.

El tubo de rayos catódicos (CRT, del inglés Cathode Ray Tube) es una tecnología que permite visualizar imágenes mediante un haz de rayos catódicos constante dirigido contra una pantalla de vidrio recubierta de fósforo y plomo. El fósforo permite reproducir la imagen proveniente del haz de rayos catódicos, mientras que el plomo bloquea los rayos X para proteger al usuario de sus radiaciones. Fue desarrollado por William Crookesen 1875. Se emplea principalmente en monitores, televisores y osciloscopios, aunque en la actualidad se está sustituyendo paulatinamente por tecnologías como plasma, LCD, LED.

El Monochrome Display Adapter (MDA) no tenía modos gráficos, ofrecía solamente un solo modo de textomonocromático (el modo de vídeo 7), que podía exhibir 80 columnas por 25 líneas de caracteres de texto de alta resolución en un monitor TTL que mostraba la imagen en verde y negro.

Tubo de rayos catódicos

Monitor CGA

Poco después y en el mismo año salieron los monitores CGA (Color Graphics Adapter –gráficos adaptados a color–) fueron comercializados en 1981 al desarrollarse la primera tarjeta gráfica a partir del estándar CGA de IBM. Al comercializarse a la vez que los MDA los usuarios de PC optaban por comprar el monitor monocromático por su costo.

Monitor EGA

Tres años más tarde, en el 1984, surgió el monitor EGA (Enhanced Graphics Adapter - adaptador de gráficos mejorados) estándar desarrollado por IBM para la visualización de gráficos, este monitor aportaba más colores (16) y una mayor resolución.

EGA es el acrónimo inglés de Enhanced Graphics Adapter, la especificación estándar de IBM PC para visualización de gráficos, situada entre CGA y VGAen términos de rendimiento gráfico (es decir, amplitud de colores y resolución). Introducida en 1984 por IBMpara sus nuevos IBM Personal Computer/AT, EGA tenía una profundidad de color de 16 colores y una resolución de hasta 640×350 píxels.

Monitor VGA

En 1987 surgió el estándar VGA (Video Graphics Array- Matriz gráfica de video) fue un estándar muy acogido.

Monitor SVGA

En 1989 se mejoró y rediseñó el estándar VGA para solucionar ciertos problemas que surgieron, desarrollando así SVGA (Super VGA), que también aumentaba colores y resoluciones, para este nuevo estándar se desarrollaron tarjetas gráficas de fabricantes hasta el día de hoy conocidos como S3 Graphics, NVIDIA o ATI entre otros.

Con este último estándar surgieron los monitores CRT que hasta no hace mucho seguían estando en la mayoría de hogares donde había un ordenador.

Comentarios

Publicar un comentario